Как выбрать решение для парсинга сайтов: классификация и большой обзор программ, сервисов и фреймворков

Содержание:

- Running Parse Server

- Скрипт Human Emulator парсинга HTML-страницы с использованием XPath

- Делаем запросы

- PHP чтение файла в переменную с помощью fread()

- cURL и аутентификация в веб-формах (передача данных методом GET и POST)

- Version 4.4.0 (2020-04-10)

- Enable result caching

- Шаг 3 – Реальный пример PHP парсинга HTML документа

- Version 3.0.0-beta1 (2016-09-16)

- Реализация парсера на PHP

- Присвоение уже назначенной буквы раздела

- API Reference

- Парсеры сайтов в зависимости от используемой технологии

- Motorola Moto G8 Plus

- Version 3.0.3 (2017-02-03)

- 10. Мэрилин Монро

- Version 4.0.0-alpha1 (2017-10-18)

- Private Tunnel

- Version 4.1.0 (2018-10-10)

- Генри Форд — Моя жизнь, мои достижения

- Разбор файла в PHP — выводы

Running Parse Server

Before you start make sure you have installed:

Locally

$ npm install -g parse-server mongodb-runner $ mongodb-runner start $ parse-server --appId APPLICATION_ID --masterKey MASTER_KEY --databaseURI mongodb://localhost/test

Note: If installation with fails due to permission problems (),

Inside a Docker container

$ git clone https://github.com/parse-community/parse-server $ cd parse-server $ docker build --tag parse-server . $ docker run --name my-mongo -d mongo

Running the Parse Server Image

$ docker run --name my-parse-server -v config-vol:/parse-server/config -p 1337:1337 --link my-mongo:mongo -d parse-server --appId APPLICATION_ID --masterKey MASTER_KEY --databaseURI mongodb://mongo/test

Note:

You can use any arbitrary string as your application id and master key. These will be used by your clients to authenticate with the Parse Server.

That’s it! You are now running a standalone version of Parse Server on your machine.

Using a remote MongoDB? Pass the parameter when starting . Learn more about configuring Parse Server . For a full list of available options, run .

Saving your first object

$ curl -X POST \

-H "X-Parse-Application-Id: APPLICATION_ID" \

-H "Content-Type: application/json" \

-d '{"score":1337,"playerName":"Sean Plott","cheatMode":false}' \

http://localhost:1337/parse/classes/GameScore

You should get a response similar to this:

{

"objectId": "2ntvSpRGIK",

"createdAt": "2016-03-11T23:51:48.050Z"

}

You can now retrieve this object directly (make sure to replace with the actual you received when the object was created):

$ curl -X GET \ -H "X-Parse-Application-Id: APPLICATION_ID" \ http://localhost:1337/parse/classes/GameScore/2ntvSpRGIK

// Response

{

"objectId": "2ntvSpRGIK",

"score": 1337,

"playerName": "Sean Plott",

"cheatMode": false,

"updatedAt": "2016-03-11T23:51:48.050Z",

"createdAt": "2016-03-11T23:51:48.050Z"

}

Keeping tracks of individual object ids is not ideal, however. In most cases you will want to run a query over the collection, like so:

$ curl -X GET \ -H "X-Parse-Application-Id: APPLICATION_ID" \ http://localhost:1337/parse/classes/GameScore

// The response will provide all the matching objects within the `results` array:

{

"results":

}

Скрипт Human Emulator парсинга HTML-страницы с использованием XPath

В этой статье мы рассмотрим один из примеров написания скрипта для парсингаHTML-страниц с использованием XPath на примере сайта bing.com.

Сперва определимся с тем, что такое XPath и зачем оно нужно, если есть регулярные выражения?

XPath (XML Path Language) — это язык запросов к элементам XML-подобного документа (далее для краткости просто XML). XPath призван реализовать навигацию по DOM в XML.

Regexp — формальный язык поиска и осуществления манипуляций с подстроками в тексте, основанный на использовании метасимволов. По сути это строка-образец (шаблон), состоящая из символов и метасимволов и задающая правило поиска.

Итак, главная разница в том, что XPath специализируется на XML, а Regexp — на любом виде текста.

В: Зачем использовать XPath, если есть regexp, в котором можно сделать тоже самое?О: Простота поддержки.

Синтаксис у regexp такой, что уже через неделю может быть проще всё переписать, чем вносить изменения, а с XPath можно спокойно работать. И синтаксис у xpath довольно компактный,xml’ё-фобы могут быть спокойны.

Простой пример для вдохновления — получим значение аттрибута «href» у, например, тега «a».

Yohoho! Regexp:

Быстро (несколько небольших страниц) пробежаться по основам XPath можно в туториале от .

Как использовать XPath в PHP можно почитать в документации на . И в небольшом тутораильчике от .

Теперь определимся с необходимым функционалом скрипта:

* Возможность указывать произвольный поисковый запрос

* Парсим только первую страницу поисковой выдачи

* Из поисковой выдачи нам нужно:

* заголовок

* ссылка

* номер в выдаче

Исходя из нашего ТЗ составляем примерный алгоритм работы скрипта:

1) Заходим на bing.com

2) Вводим поисковую фразу

3) Получаем со страницы необходимый результат

Приступим к написанию парсера поисковой выдачи http://bing.com. Для начала, создадим базовый каркас скрипта.

// coding: windows-1251 // Настройка HumanEmulator // ———————————————— // Где запущен XHE $xhe_host = «127.0.0.1:7010»; // HumanEmulator lib require «../../Templates/xweb_human_emulator.php»; // Our tools require «tools/functions.php»; // Настройки скрипта // ———————————————— // Скрипт // ———————————————— // Quit $app->quit();

В настройки добавим переменную для хранения поискового запроса.

// Поисковый запрос $text = «ХуманЭмулятор»;

Заходим на сайт.

// Базовый URL $base_url = «https://www.bing.com/?setlang=en»; $browser->navigate($base_url);

Вводим поисковую фразу.

$input->set_value_by_attribute(«name», «q», true, $text); sleep(1); $element->click_by_attribute(«type», «submit»); sleep(5);

Сохраним в переменную содержимое страницы.

// Получаем содержимое страницы $content = $webpage->get_body();

Настроим xpath-объект:

$dom = new DOMDocument; @$dom->loadHTML($content); $xpath = new DOMXpath($dom);

Теперь у объекта $xpath есть метод «query» в который мы будемпередавать наше xpath-выражение. Давайте начнём создавать xpath-выражение.Открыв исходный код страницы с результатами поисковой выдачи увидим, что сами результаты находятся внутри тега «li».

Т.о. наше xpath-выражение выберет со страницы все поисковые результаты.

$results = $xpath->query(«//li»);

На одной странице у нас должно быть 1 или больше результатов, проверим себя:

if($results === false) { echo «С нашим xpath-выражением что-то не так.» . PHP_EOL; $app->quit(); } elseif($results->length === 0) { echo «Поисковый запрос ‘{$text}’ не принёс результатов.» . PHP_EOL: $app->quit(); } echo «Нашли {$results->length} совпадений.» . PHP_EOL;

Здесь стоит обратить внимание на ветку if, где мы сравниваем кол-во результатов xpath-поиска с нулём. Если наше xpath-выражение ничего не нашло, то это может означать две вещи:* Bing действительно ничего не нашёл

* Bing что-то нашёл, но поменял вёрстку на странице, и наше xpath-выражение необходимо исправлять.

2-й пункт достаточно коварный, в таких случаях, когда xpath-выражение ничего не находит необходимо дополнительно сверятся, чтобы удостоверится, что xpath-выражение не устарело (хотя и это не даст 100% гарантий). В нашем случае будем сверяться с тем, что Bing пишет кол-во найденных результатов.

14 results

А если результатов по поисковому запросу нет, то:

Делаем запросы

Интерфейс класса достаточно простой и прямолинейный. Имена методов соответствуют HTTP-методам, которые он выполняет: GET-метод соответствует методу get(), GET-post(), PUT-put() и т.д. И каждый из этих методов возвращает Promise (если вы знакомы с JavaScript, или ранее работали с ReactPHP, то это не должно вызвать у вас вопросов). Если вы не знаете, что это, то на даном этапе объяснения не имеют большого смысла, дальше будет пример, после которого всё станет понятно.

Для текущей задачи нам будет достаточно одного метода :

В коде выше будет описана анонимная функция, которая после успешного запроса выведет HTML-разметку на экран. Эта функция принимает ответ экземпляра . В этой функции мы можем описать обработчик ответа, который вернёт из этого промиса (Promise) распарсенную информацию, без лишнего HTML-кода.

Как вы можете заметить, алгоритм парсинга достаточно прост:

- Делаем запрос и получаем промис.

- Пишем обработчик этого промиса.

- Парсим нужную информацию внутри этого обработчика.

- Если нужно, повторяем первый шаг.

PHP чтение файла в переменную с помощью fread()

Ещё одной функцией PHP для разбора файла является fread(), с помощью которой можно читать различные фрагменты файла указанной длины. Чтобы прочитать файл в PHP целиком, в качестве размера фрагмента я указал размер файла, полученный с помощью функции filesize():

<?php

$filename = "users.txt";

if (file_exists($filename) && is_readable ($filename)) {

$fp = @fopen($filename, 'r');

if ($fp) {

$lines = explode("\n", fread($fp, filesize($filename)));

}

if (!empty($lines)) {

foreach ($lines as $line) {

if (!empty($line)) {

$params = explode(':', $line);

if (!empty($params) && !empty($params) && $params != 'Fake') {

$client = Clients::model()->find('unique_id IN (:id1, :id2)', array(':id1' => strtolower($params), ':id2' => strtoupper($params)));

if ($client) {

$client->phone = str_replace(array("\r", "\n"), "", $params);

$client->save();

}

}

}

}

}

else echo "Check the filename, file doesn't exists!";

}

Данный способ чтения файла PHP средствами, на самом деле, очень похож на предыдущий, т.к., несмотря на то, что с помощью PHP данные из файла изначально считываются не в массив, а в строковую переменную, далее она всё равно преобразуется в массив, т.к. с ним проще работать, чем со строкой.

Преобразование строки в массив на PHP проще всего сделать с помощью уже применявшейся сегодня функции explode(), в качестве разделителя в которую был передан символ начала строки.

А дальше всё идёт по накатанной

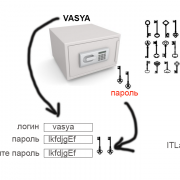

cURL и аутентификация в веб-формах (передача данных методом GET и POST)

Аутентификация в веб-формах – это тот случай, когда мы вводим логин и пароль в форму на сайте. Именно такая аутентификация используется при входе в почту, на форумы и т. д.

Использование curl для получения страницы после HTTP аутентификации очень сильно различается в зависимости от конкретного сайта и его движка. Обычно, схема действий следующая:

1) С помощью Burp Suite или Wireshark узнать, как именно происходит передача данных. Необходимо знать: адрес страницы, на которую происходит передача данных, метод передачи (GET или POST), передаваемая строка.

2) Когда информация собрана, то curl запускается дважды – в первый раз для аутентификации и получения кукиз, второй раз – с использованием полученных кукиз происходит обращение к странице, на которой содержаться нужные сведения.

Используя веб-браузер, для нас получение и использование кукиз происходит незаметно. При переходе на другую страницу или даже закрытии браузера, кукиз не стираются – они хранятся на компьютере и используются при заходе на сайт, для которого предназначены. Но curl по умолчанию кукиз не хранит. И поэтому после успешной аутентификации на сайте с помощью curl, если мы не позаботившись о кукиз вновь запустим curl, мы не сможем получить данные.

Для сохранения кукиз используется опция —cookie-jar, после которой нужно указать имя файла. Для передачи данных методом POST используется опция —data. Пример (пароль заменён на неверный):

curl --cookie-jar cookies.txt http://forum.ru-board.com/misc.cgi --data 'action=dologin&inmembername=f123gh4t6&inpassword=111222333&ref=http%3A%2F%2Fforum.ru-board.com%2Fmisc.cgi%3Faction%3Dlogout'

Далее для получения информации со страницы, доступ на которую имеют только зарегестрированные пользователи, нужно использовать опцию -b, после которой нужно указать путь до файла с ранее сохранёнными кукиз:

curl -b cookies.txt 'http://forum.ru-board.com/topic.cgi?forum=35&topic=80699&start=3040' | iconv -f windows-1251 -t UTF-8

Эта схема может не работать в некоторых случаях, поскольку веб-приложение может требовать указание кукиз при использовании первой команды (встречалось такое поведение на некоторых роутерах), также может понадобиться указать верного реферера, либо другие данные, чтобы аутентификация прошла успешно.

Version 4.4.0 (2020-04-10)

Added

- Added support for passing union types in builders.

- Added end line, token position and file position information for comments.

- Added method to nodes.

Fixed

- Fixed generation of invalid code when using the formatting preserving pretty printer, and

inserting code next to certain nop statements. The formatting is still ugly though. -

no longer requires that the very last comment before a node be a doc comment.

There may not be non-doc comments between the doc comment and the declaration. - Allowed arbitrary expressions in and , rather than just variables.

In particular, this allows , which is legal PHP code.

Enable result caching

WhichBrowser supports PSR-6 compatible cache adapters for caching results between requests. Using a cache is especially useful if you use WhichBrowser on every page of your website and a user visits multiple pages. During the first visit the headers will be parsed and the result will be cached. Upon further visits, the cached results will be used, which is much faster than having to parse the headers again and again.

For example, if you want to enable a memcached based cache you need to install an extra composer package:

And change the call to WhichBrowser/Parser as follows:

$client = new \Memcached();

$client->addServer('localhost', 11211);

$pool = new \Cache\Adapter\Memcached\MemcachedCachePool($client);

$result = new WhichBrowser\Parser(getallheaders(), );

or

$client = new \Memcached();

$client->addServer('localhost', 11211);

$pool = new \Cache\Adapter\Memcached\MemcachedCachePool($client);

$result = new WhichBrowser\Parser();

$result->setCache($pool);

$result->analyse(getallheaders());

You can also specify after how many seconds a cached result should be discarded. The default value is 900 seconds or 15 minutes. If you think WhichBrowser uses too much memory for caching, you should lower this value. You can do this by setting the option or passing it as a second parameter to the function.

Шаг 3 – Реальный пример PHP парсинга HTML документа

Для примера парсинга, и приведения HTML DOM библиотеки

в действие, мы напишем грабер материалов на сайте sitear.ru. Далее мы выведем все статьи в виде

списка, в котором будут указаны названия статей. При написании граберов,

помните, кража контента преследуется законом! Но не в случае, когда на странице

стоит активная ссылка на исходный документ.

include('simple_html_dom.php');

$articles = array();

getArticles('http://sitear.ru/');

Начинаем с подключения библиотеки, и вызова функции getArticles, которая будет парсить HTML документы

соответственно адресу страницы, которая передается в качестве параметра

функции.

Также мы указываем глобальный массив, в котором будет,

хранится вся информация о статьях. Перед тем как начать парсинг HTML документа,

давайте посмотрим, как он выглядит.

<div class="title_material"> <div class="name_material"><a href="…">Название материала</a></div> <div class="views_material">Просмотров: <b>35</b></div> </div> <div class="description"> Описание статьи…</div>

Это базовый шаблон данной страницы. При написании парсера html, нужно тщательно исследовать

документ, так как и комментарии, типа <!—comment—>, это тоже потомки. Другими словами, в глазах

библиотеки simple HTML DOM,

это элементы, которые равноценны другим тегам страницы.

Version 3.0.0-beta1 (2016-09-16)

Added

- Function/method and parameter builders now support PHP 7.1 type hints (void, iterable and

nullable types). - Nodes and Comments now implement . The node kind is stored in a

property. - The node now has an attribute, that specifies whether the

preceding closing tag contained a newline. The pretty printer honors this attribute. - Partial parsing of (with missing property name) is now supported in error recovery mode.

- The error recovery mode is now exposed in the script through the

or flags.

The following changes are also part of PHP-Parser 2.1.1:

- The PHP 7 parser will now generate a parse error for assignments.

- Comments on free-standing code blocks will now be retained as comments on the first statement in

the code block.

Реализация парсера на PHP

Пожалуй, самый ответственный момент в нашем случае — это поиск донора, то есть сайта, на котором будет появляться интересующая нас информация. Сайт должен работать бесперебойно, выполнять свои обязанности по обновлению информации исправно и текст должен быть открытый (то есть, открыв исходный код страницы в браузере — мы должны видеть там интересующую нас информацию).

Когда сайт-донор и нужная нам страница для парсинга найдена, запоминаем ее урл и переходим к следующему этапу. Создаем в блокноте текстовый файл, например parser.php и помещаем в него следующий код:

<?php

//откуда будем парсить информацию

$content = file_get_contents('полный урл страницы с http:// с которого будем вырезать информацию');

// Определяем позицию строки, до которой нужно все отрезать

$pos = strpos($content, 'здесь кусок кода/текста который размещен перед нужным текстом');

//Отрезаем все, что идет до нужной нам позиции

$content = substr($content, $pos);

// Точно таким же образом находим позицию конечной строки

$pos = strpos($content, 'здесь кусок кода/текста который стоит в конце нужного нам текста');

// Отрезаем нужное количество символов от нулевого

$content = substr($content, 0, $pos);

//если в тексте встречается текст, который нам не нужен, вырезаем его

$content = str_replace('текст который нужно вырезать','', $content);

// выводим спарсенный текст.

echo $content;

echo "вставляем сюда завершающий код";

?>

Итак, какие-то 8 строчек кода и сторонний контент автоматически публикуется на нашем блоге. Красным цветом в коде обозначены места, которые вы обязательно должны отредактировать, зеленым цветом — при необходимости. Если необходимости нет, то можно просто удалить эти строчки или запретить им обрабатываться (я про строчки в которых зеленый текст) — ставим перед строчкой два слеша — //

Нужны пояснения к кускам кода/текста, которые обрамляют нужный нам текст? Тут все просто, мы должны указать начальную и конечную позицию в тексте, который нужно парсить. Открываем исходную страницу на сайте-доноре и ищем нужный нам текст. Как правило, он будет начинаться с какой нибудь html-разметки, что-то типа этого — <td><p><strong><em> и заканчиваться такой же абракадаброй — например, </td><td> </td><td> </td></tr>. Копируем эти символы в начальную и конечную позиции (2 и 3 красная строчки). Помним, наш скрипт спарсит текст, который находится между этими позициями на сайте.

parser.php готов. Копируем его в корень своего сайта и запускаем в браузере http://мой сайт/parser.php. Если вы все сделали правильно, вы увидите вырезанный/спарсенный кусок текста. Разумеется, он индексируется и не содержит никаких следов того, что вы его забрали с другого сайта.

Присвоение уже назначенной буквы раздела

Такого типа проблема встречается довольно часто. Это происходит при подключении SD карты к компьютеру, система присваивает ей туже букву, что и существующему разделу, из-за этого происходит конфликт и мы не видим нашу флешку в перечне дисков компьютера.

Для того чтобы устранить такого типа проблему открыть раздел «Управления компьютером» выше описан способ открытия этого раздела.

После попадания в раздел «Управления дисками» нам необходимо найти нашу флешку, ориентируйтесь на её объем, выбираем диск, совпадающий с объёмом нашей Micro SD карты. Нажимаем по нему правой кнопкой мыши и в выпавшем меню выбираем пункт «Изменить букву диска или путь к диску …».

Откроется окно, в котором нам необходимо нажать кнопку «Добавить».

В открывшемся окне выбираем букву этому разделу и нажимаем «ОК».

Готово, мы задали букву нашему разделу, теперь проверяем его наличие в проводнике.

API Reference

Helper functions

| Name | Description |

|---|---|

| object str_get_html ( string $content ) | Creates a DOM object from a string. |

| object file_get_html ( string $filename ) | Creates a DOM object from a file or a URL. |

DOM methods & properties

| Name | Description |

|---|---|

|

void __construct ( ) |

Constructor, set the filename parameter will automatically load the contents, either text or file/url. |

|

string plaintext |

Returns the contents extracted from HTML. |

|

void clear () |

Clean up memory. |

|

void load ( string $content ) |

Load contents from a string. |

|

string save ( ) |

Dumps the internal DOM tree back into a string. If the $filename is set, result string will save to file. |

|

void load_file ( string $filename ) |

Load contents from a from a file or a URL. |

|

void set_callback ( string $function_name ) |

Set a callback function. |

|

mixed find ( string $selector ) |

Find elements by the CSS selector. Returns the Nth element object if index is set, otherwise return an array of object. |

Element methods & properties

| Name | Description |

|---|---|

| string | Read or write element’s attribure value. |

|

string tag |

Read or write the tag name of element. |

|

string outertext |

Read or write the outer HTML text of element. |

|

string innertext |

Read or write the inner HTML text of element. |

|

string plaintext |

Read or write the plain text of element. |

|

mixed find ( string $selector ) |

Find children by the CSS selector. Returns the Nth element object if index is set, otherwise, return an array of object. |

DOM traversing

| Name | Description |

|---|---|

|

mixed $e->children ( ) |

Returns the Nth child object if index is set, otherwise return an array of children. |

|

element $e->parent () |

Returns the parent of element. |

|

element $e->first_child () |

Returns the first child of element, or null if not found. |

|

element $e->last_child () |

Returns the last child of element, or null if not found. |

|

element $e->next_sibling () |

Returns the next sibling of element, or null if not found. |

|

element $e->prev_sibling () |

Returns the previous sibling of element, or null if not found. |

Парсеры сайтов в зависимости от используемой технологии

Парсеры на основе Python и PHP

Такие парсеры создают программисты. Без специальных знаний сделать парсер самостоятельно не получится. На сегодня самый популярный язык для создания таких программ Python. Разработчикам, которые им владеют, могут быть полезны:

- библиотека Beautiful Soup;

- фреймворки с открытым исходным кодом Scrapy, Grab и другие.

Заказывать разработку парсера с нуля стоит только для нестандартных задач. Для большинства целей можно подобрать готовые решения.

Парсеры-расширения для браузеров

Парсить данные с сайтов могут бесплатные расширения для браузеров. Они извлекают данные из html-кода страниц при помощи языка запросов Xpath и выгружают их в удобные для дальнейшей работы форматы — XLSX, CSV, XML, JSON, Google Таблицы и другие. Так можно собрать цены, описания товаров, новости, отзывы и другие типы данных.

Примеры расширений для Chrome: Parsers, Scraper, Data Scraper, kimono.

Парсеры сайтов на основе Excel

В таких программах парсинг с последующей выгрузкой данных в форматы XLS* и CSV реализован при помощи макросов — специальных команд для автоматизации действий в MS Excel. Пример такой программы — ParserOK. Бесплатная пробная версия ограничена периодом в 10 дней.

Парсинг при помощи Google Таблиц

В Google Таблицах парсить данные можно при помощи двух функций — importxml и importhtml.

Функция IMPORTXML импортирует данные из источников формата XML, HTML, CSV, TSV, RSS, ATOM XML в ячейки таблицы при помощи запросов Xpath. Синтаксис функции:

IMPORTXML("https://site.com/catalog"; "//a/@href")

IMPORTXML(A2; B2)

Расшифруем: в первой строке содержится заключенный в кавычки url (обязательно с указанием протокола) и запрос Xpath.

Знание языка запросов Xpath для использования функции не обязательно, можно воспользоваться опцией браузера «копировать Xpath»:

Вторая строка указывает ячейки, куда будут импортированы данные.

IMPORTXML можно использовать для сбора метатегов и заголовков, количества внешних ссылок со страницы, количества товаров на странице категории и других данных.

У IMPORTHTML более узкий функционал — она импортирует данные из таблиц и списков, размещенных на странице сайта. Синтаксис функции:

IMPORTHTML("https://https://site.com/catalog/sweets"; "table"; 4)

IMPORTHTML(A2; B2; C2)

Расшифруем: в первой строке, как и в предыдущем случае, содержится заключенный в кавычки URL (обязательно с указанием протокола), затем параметр «table», если хотите получить данные из таблицы, или «list», если из списка. Числовое значение (индекс) означает порядковый номер таблицы или списка в html-коде страницы.

Motorola Moto G8 Plus

-

Дисплей: 6,3 дюйма, FHD+, IPS

-

Процессор: Snapdragon 665

-

Память: 4/64 Гб

-

ЦАП: отсутствует

-

Батарея: 4000 мАч

Цена: от 16 000 руб.

Бюджетные смартфоны довольно редко оснащаются стереодинамиками, но модель от Motorola в этом плане стала приятным исключением. Аппарат имеет действительно качественное звучание. Смотреть на нем фильмы или слушать музыку без наушников вполне комфортно. На этом фишки модели не закончились – есть защита от брызг P2i, NFC, разъем 3,5 и тройная камера 48+5+16 Мп. Фронтальная камера – 25 Мп.

Достоинства:

-

Быстрая зарядка.

-

Качественная фотокамера и интересные режимы для съемки.

-

Есть NFC.

-

Приятное звучание.

-

Защита от брызг.

-

Неплохая производительность.

Недостатки:

-

Смартфоны Motorola всегда внешне отличались от конкурентов, G8 Plus – это типичный девайс с Андроид без ярко-выраженных особенностей.

-

Комбинированный слот.

-

Маркий корпус.

Version 3.0.3 (2017-02-03)

Fixed

- In the is now parsed as an rather than . (#325)

- Ensure integers and floats are always pretty printed preserving semantics, even if the particular

value can only be manually constructed. - Throw a when trying to pretty-print an node. Previously this resulted in

an undefined method exception or fatal error.

Added

- Added support for negative interpolated offsets:

- Added option to . If this option is enabled, an

attribute, containing the unresolved name, will be added to each resolved name. - Added option, which dumps nodes with position information.

Deprecated

The XML serializer has been deprecated. In particular, the classes Serializer\XML,

Unserializer\XML, as well as the interfaces Serializer and Unserializer are deprecated.

10. Мэрилин Монро

Version 4.0.0-alpha1 (2017-10-18)

Added

- Added experimental support for format-preserving pretty-printing. In this mode formatting will be

preserved for parts of the code which have not been modified. - Added option to , defaulting to true. If this option is disabled,

resolved names will be added as attributes, instead of replacing the original

names. - Added class, which can be used to find nodes based on a callback or class name. This

is a utility to avoid custom node visitor implementations for simple search operations. - Added method.

- Added methods: method for creating an AST for a simple value,

for creating concatenation trees, for preparing function arguments. - Added class, which encapsulates the logic independently of the actual

AST traversal. This facilitates use in other context, such as class names in doc comments.

Additionally it provides an API for getting the shortest representation of a name. - Added method.

- Added . This allows conversion JSON back into an AST.

- Added methods and .

- Added and nodes, which are used in place of simple strings in

many places. - Added , , , , ,

and methods to . These provide a more obvious access

point for the already existing attributes of the same name. - Added to evaluate constant expressions to PHP values.

- Added , returning for , etc.

Changed

- Many subnodes that previously held simple strings now use (or )

nodes. Please see the UPGRADE-4.0 file for an exhaustive list of affected nodes and some notes on

possible impact. - Expression statements () are now represented using a node. Previously

these statements were directly represented as their constituent expression. - The subnode of has been renamed to and now contains a rather than

a plain string. - The subnode of has been renamed to and now contains a rather

than a plain string. - The subnode of now contains a rather than a plain string.

- The subnode of now contains a rather than a plain string.

- The subnode of is now if no explicit alias is given. As such,

and are now represented differently. The method

can be used to get the effective alias, even if it is not explicitly given.

Removed

- Support for running on PHP 5 and HHVM has been removed. You can however still parse code of old

PHP versions (such as PHP 5.2), while running on PHP 7. - Removed subnode on , and nodes. Use instead.

- The method has been removed. Constants cannot have a static modifier.

- The no longer accepts as a return value from a method.

should be returned instead. - The method has been removed. If you really need to, you can use

instead. - The misspelled constant has been dropped in favor of

. - The XML serializer has been removed. As such, the classes , and

, as well as the interfaces and no longer exist. - The class has been removed. It’s functionality is moved into .

However, this is an internal class and should not be used directly.

Private Tunnel

Version 4.1.0 (2018-10-10)

Added

- Added support for PHP 7.3 flexible heredoc/nowdoc strings, completing support for PHP 7.3. There

are two caveats for this feature:- In some rare, pathological cases flexible heredoc/nowdoc strings change the interpretation of

existing doc strings. PHP-Parser will now use the new interpretation. - Flexible heredoc/nowdoc strings require special support from the lexer. Because this is not

available on PHP versions before 7.3, support has to be emulated. This emulation is not perfect

and some cases which we do not expect to occur in practice (such as flexible doc strings being

nested within each other through abuse of variable-variable interpolation syntax) may not be

recognized correctly.

- In some rare, pathological cases flexible heredoc/nowdoc strings change the interpretation of

- Added to to skip both traversal of child

nodes, and prevent subsequent visitors from visiting the current node.

Генри Форд — Моя жизнь, мои достижения

Автобиография великого изобретателя и создателя известнейшей компании в мире. В ней он поделится своим мнением о бизнесе и принципами, которыми он руководствовался при его создании.

Он расскажет о своей непростой жизни, взлетах и падениях, судебных разбирательствах, в которых ему приходилось участвовать, о полном разорении и получении огромного состояния. В книге приведены примеры многих сложных производственных процессов, которые разработал и запустил в собственный бизнес сам автор.

Генри Форд был не только гениальным изобретателем, но и талантливым менеджером. Его секреты управления используются во многих компаниях и по сей день. Эта книга послужит настоящим учебником для начинающих бизнесменов.

Купить электронную книгу в ЛитРес

Купить аудиокнигу в ЛитРес

Купить бумажную книгу в Лабиринте

Разбор файла в PHP — выводы

Как я уже и говорил в начале, мои опыты не являются безупречными и опираться исключительно на полученные в их ходе результаты не стоит, т.к., несмотря на быстродействие file_get_contents() в моей ситуации, бывают случаи, когда намного удобнее и эффективнее использовать другие приведённые мною PHP парсеры файлов.

Кроме того, не стоит забывать, что PHP сам по себе является синхронным языком программирования, т.е. все серверные операции происходят последовательно без возможности настройки их параллельного выполнения, в том числе, и на разных ядрах серверного процессора.

Следовательно, на время выполнения операций, прописанных в PHP коде, может влиять целый ряд факторов, среди которых основным является нагруженность ядра в момент работы PHP приложения.

Я это особенно ощутил во время проведения опытов, когда один и тот же PHP парсер файла отработал за 9, затем за 12, а потом снова за 9 секунд на трёх последовательных итерациях из-за банального запуска проводника Windows во время второго случая, который, естественно, тоже требует серверных ресурсов.

Учитывая данные особенности, я проводил эксперименты практически одновременно, друг за другом, при одинаковом комплекте запущенных программ, чтобы не распылять ресурсы серверного железа.

Поэтому в дальнейшем, при проведении подобных экспериментов с PHP конструкциями действуйте аналогичным образом, т.к. это, по сути, единственный способ привести эксперименты к равным условиям.

Если же вы будете работать с асинхронными серверными языками (C#, Java) или технологиями (Node.js, например), то, по возможности, для экспериментов создавайте отдельный поток, который будет работать на выделенном ядре процессора.

Ну, а если найти полностью незадействованное ядро не получится (что при уровне современного ПО не удивительно), то вы хотя бы сможете найти самое слабонагруженное или, хотя бы, со статической нагрузкой, которая не меняется во времени.

Надеюсь, что мои наблюдения и рекомендации будут вам полезны, равно как и мои сегодняшние эксперименты с PHP парсерами файлов.

Подытоживая, хочу сказать, что приведённые в статье фрагменты кода могут использоваться не только для парсинга текстовых файлов в PHP, но и отлично подойдут для других форматов, например, для разбора CSV файлов дампа базы данных MySQL.

До новых встреч!