Как проверить индексацию сайта в яндексе и google

Содержание:

- Мир

- Дублирование

- Загрузка файлов на сервер с прогрессом и докачкой

- Различия индексации сайта в Google и «Яндексе»

- Robots.txt

- Анализ индексации сайта

- Используем панель Вебмастера

- Полезные ссылки

- Особенности индексирования сайтов с разными технологиями

- Как сохранить метку на карте

- В Яндексе и Google разное количество проиндексированных страниц: что делать?

- Почему индексация должна быть быстрой?

- Как проверить индексацию отдельной или всех страниц

Мир

Дублирование

Подразумевает наличие нескольких идентичных страниц одного сайта, в которых содержится одинаковый контент.

Виды дублей:

-

страницы, адрес которых различается знаком «/». Например, «www.primer_saita.ru/Tovar/cart/GM928» и абсолютно аналогичный «…/GM928/». Часто встречается такая ситуация с карточкой одного и того же товара, которая относится к разным категориям (коньки, подходящие, как для девочек, так и для мальчиков);

-

дубли-страницы с незначащими параметрами, которые не воспринимает робот-поисковик. Примеры некоторых незначащих элементов для робота-поисковика, можно увидеть ниже:

Неприятности, которые могут возникнуть из-за дублей:

-

бот поисковой системы, вместо индексации необходимого и корректного адреса может посещать и анализировать множество ненужных страниц;

-

в базу данных поиска робот-анализатор может включить только одну страницу из всех возможных дублей, опираясь на свое усмотрение.

Как бороться с дублированными страницами:

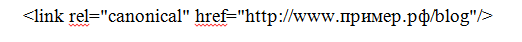

Прописать атрибут rel= «canonical» тега со своим значением, то есть «выделить» страницу, расставив «приоритеты» цепочкой. Например, есть две страницы:

Допустим, что предпочитаемый адрес, который нам нужен – это вторая ссылка. Тогда, в первой странице необходимо прописать в ее html-коде следующую строчку:

Важно! Алгоритм анализа поисковым роботом устроен таким образом, что не считает данную директиву строгой, поэтому бот рассматривает ее, как предполагаемый вариант, который может быть проигнорирован!

-

«редирект 301», о котором мы уже говорили ранее. Особенно актуален в случаях дублей страниц с «/» и без него;

-

В файле robots.txt прописать параметры «disallow» (запрет доступа) и «clean-param» (учитывание динамических параметров (id сессий и др.), не влияющие на содержимое страницы). Пример таких дублей мы рассмотрели чуть ранее.

Где можно выявить дубли? Все в том же Вебмастере. В сервисе от «Яндекса» заходим в раздел «Индексирование», затем «Проверить статус URL», вводим ссылку, анализируем результат.

Загрузка файлов на сервер с прогрессом и докачкой

Различия индексации сайта в Google и «Яндексе»

Основное различие поисковых систем «Гугл» и «Яндекс» заключается в региональной принадлежности. Если Yandex работает только в русскоязычной части Интернета, то Google является международным поисковиком. Свои системы поиска есть практически в каждой стране. В некоторых случаях региональные сервисы могут составлять серьезную конкуренцию «Гуглу» («Яндекс» в РФ, Seznam – в Чехии, Baidu – в КНР и т. д.). Подтверждением этого факта могут служить переговоры по вопросам выкупа сервиса Yandex компанией «Гугл», которые имели место в 2003 году. Пока такое поглощение не состоялось.

У каждой поисковой системы есть свои программы ботов, осуществляющие проверку сайтов на предмет релевантности и качества представленного на них контента. При этом стандарты работы таких роботов постоянно совершенствуются. Нужно отметить, что разработчики не открывают полностью суть алгоритмов индексации, поэтому специалисты постоянно анализируют поисковые программы и на основании имеющихся практических данных формируют определенные выводы.

Рекомендуемые статьи по данной теме:

- Внутренняя оптимизация сайта: пошаговый разбор

- Проверка robots.txt: типичные ошибки и их устранение

- Редирект с http на https: повышаем безопасность сайта

Требования, которые предъявляют «Гугл» и «Яндекс» к индексации сайтов, имеют много общего. Поэтому можно сформулировать некоторые универсальные рекомендации:

Нужно уделять больше внимание качеству контента (уникальность, полезность и грамотность)

Программные и орфографические ошибки четко отслеживаются ботами и снижают индекс авторитетности сайта.

Интернет-площадки должны иметь понятную структуру

Важно, чтобы они были удобными для пользователей и содержали важную и ценную информацию.

Следует качественно проработать страницы контактов и обратной связи, разместить портфолио и отзывы, а также описать имеющиеся достижения.

На сайте нужно разместить работающие исходящие ссылки.

Контент на интернет-площадках должен постоянно обновляться, а их функционал следует дорабатывать с учетом различных нововведений и инноваций. Все это учитывается поисковиками при ранжировании сайтов.

Поисковая система «Яндекса» имеет два робота – основной и быстрый (Orange). Первый осуществляет индексацию Сети в целом, а второй обеспечивает возможность быстрого поиска наиболее свежей и актуальной информации по запросу пользователя. Каждый робот имеет перечень данных, которые необходимо проиндексировать.

По мнению экспертов, «Яндекс» работает медленнее, чем «Гугл». Но при этом поисковая система Рунета индексирует полезные материалы и исключает из выдачи «лишние» результаты.

Преимущество «Гугла» заключается в его универсальности. «Яндекс» же развивается исключительно в русскоязычном Интернете (попытки выйти на другие рынки имели место, но пока не увенчались успехом).

Система Yandex ориентирована на поиск по запросам из ограниченного перечня регионов. Но именно региональный характер во многом определяет его успешность. В настоящее время «Гугл» и «Яндекс» занимают в русскоязычном Интернете примерно одинаковые ниши.

В интернет-пространстве других стран поисковая система Yandex не получила распространение, так как наиболее значимыми факторами поиска там выступают язык и местонахождение пользователя. На основании этих критериев и строится поисковая выдача «Гугла». В системе «Яндекс» индексация по языковым признакам не происходит. Несмотря на то, что этот поисковик определяет место нахождения пользователя, он не учитывает этот фактор при обработке запроса. Классифицировать сайты Рунета по регионам в зависимости от языка запроса не получается. «Яндекс» может настраивать поисковую выдачу исключительно по территориальному признаку, в чем и заключается уникальность этой системы.

Не так давно Yandex запустил новый инструмент – поиск «Андромеда». После этого поисковик предлагает определенные места в городах, дает возможность собирать коллекции пользователя, информирует о событиях из мира спорта, отмечает статус интернет-ресурсов особыми значками в зависимости от их благонадежности и популярности. Каким образом новый инструмент может влиять на индексацию, еще не совсем ясно.

Важным нововведением 2018 года является замена показателя ТИЦ (индекс цитирования) на ИКС (индекс качества сайта). Новый показатель необходимо учитывать при продвижении ресурса.

Robots.txt

Это файл, который можно отредактировать в любом текстовом редакторе. Преимущество и одновременно необходимость состоим в том, что он прописывает строгие инструкции для роботов поиска различных поисковых систем. Располагают роботс.тхт в корневой папке сайта.

Наиболее популярные ошибки, возникающие при работе с данным файлом:

-

закрытие действительно нужных страниц сайта. Чаще всего эта ошибка связана с незнанием всех аспектов и нюансов правильного заполнения;

-

использование кириллических символов в файле не допускается;

-

одни и те же правила для разных роботов. Нюанс, о котором часто забывают. Согласитесь, что даже на вид «Яндекс» и «Google» сильно отличаются друг от друга. Что тогда говорить о внутренних алгоритмах ранжирования и поисковых роботах?! Соответственно, и правила надо прописывать разные, так как один бот их примет, а другой даже не обратит внимания, а может и сразу уйдет, не завершив процесс индексирования.

-

использование директивы «crawl-delay» (определяет частоту запросов поискового бота и часто используется в тех случаях, когда сервер подвержен сильной нагрузке) без необходимости. Реальный пример: был сайт-визитка на самом дешевом хостинге. В него добавили каталог, содержащий около 10 000 товаров. Робот-поисковик начал скачивать и анализировать информацию и из-за ее объема стал не успевать ее обрабатывать. Многие страницы стали недоступны, выдавая 404-ую ошибку. Логичное решение – выставить директиву «crawl-delay». Поставили, все начало работать. Затем, в связи с разрастанием сайта, было решено перенести веб-ресурс на другой хостинг-провайдер, учтя при этом заранее параметры нагрузки сервера. Вроде все замечательно, а директиву «кроул» убрать забыли!!! В результате нагрузка на сервер минимальная, робот «не спешит» все обрабатывать и на выходе – очень долгое время индексации сайта.

Проверить файл с инструкциями для роботов можно, используя сервисы вебмастера от «Яндекс» или «Гугл». В «Yandex.Webmaster» достаточно зайти в раздел «Инструменты», затем в «анализ robots.txt». Загрузить файл и его вставить непосредственно в поле, посмотреть рекомендации или ошибки, которые необходимо будет исправить.

Анализ индексации сайта

Перед тем как приступать к продвижению сайта, стоит убедиться, что все его страницы включены в индексы поисковых систем – «Гугла», «Яндекса» и других

Почему это важно?

- Не прошедшая индексацию страница не видна пользователям, и все ваши затраты, и временные, и материальные, будут напрасными. Только те страницы, которые попали в индекс, приносят вам посетителей и соответствующую выгоду.

- Отсутствие страницы в базе поисковой системы может быть признаком технических проблем, таких как дублирование контента и внутренние глюки ресурса или хостинга.

- Если на странице размещены платные ссылки, а в индексе ее нет, она выпадает из схемы перелинковки, следовательно, вы не получите ожидаемой прибыли.

Предлагаем подробно ознакомиться с ручными и автоматизированными способами, позволяющими проверить индексацию всего сайта и отдельных страниц в «Яндексе» и Google.

Для того чтобы узнать количество страниц на сайте, применяют несколько методов:

- Скорее всего, используемая вами система управления сайтом достаточно современна, а значит, количество страниц можно узнать в административной части.

- Есть еще один способ – воспользоваться программой Xenu, найти которую в «Яндексе» не составит труда. В результате полного сканирования сайта она выдает список страниц, перечень битых ссылок и другие необходимые сведения. Однако, чтобы разобраться с тем, как она работает, понадобится время.

Итак, число страниц на сайте нам известно. Проверим, какое количество из них внесено в индекс Google и «Яндекса».

Речь идет о том, сколько страниц всего проиндексировано поисковиками. Для чего нам нужна эта информация? Чтобы сравнить общее количество страниц с числом внесенных в базу данных поисковых систем. Оптимальный вариант – полное соответствие этих значений. Если эти числа не совпадают, придется разбираться, какие страницы не проиндексированы, а какие имеют дубли.

Вас также может заинтересовать: Проверка тИЦ сайта: 3 способа

Используем панель Вебмастера

Каждая поисковая система имеет свою панель инструментов, специально предназначенную для вебмастеров. С помощью этой панели можно увидеть общее количество проиндексированных страниц. Рассмотрим на примере самых популярных ПС (Яндекс и Google), как выполнять такую проверку.

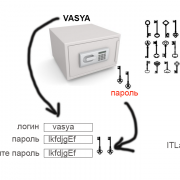

Чтобы использовать панель инструментов Яндекс в данном контексте, нужно завести аккаунт (если его еще нет), зайти в панель и добавить в нее свой сайт. Там будет показано общее количество страниц, которые уже проиндексированы.

Для использования панели инструментов Google также нужно обзавестись аккаунтом, чтобы иметь возможность зайти в панель. В нее нужно добавить свой сайт и зайти на вкладку «Состояние / Статус индексирования». Здесь также будет показано количество проиндексированных страниц.

Нередко можно заметить, что панель Вебмастера Google может показать значительно большее количество проиндексированных страниц, чем панель инструментов Яндекс. Представим, что на сайте 70 уникальных страниц, которые проиндексировались. И, скажем, Яндекс насчитал приблизительно такое количество ссылок, а Гугл, например, 210. Получается, что Яндекс показал правильное число, а Гугл в 3 раза больше. Так в чем же дело? А дело в дублях страниц, генерируемых движком WordPress. Такие дубли поисковикам не по душе. Использование robots.txt позволяет игнорировать индексацию дублей страниц поисковыми системами. И если на Яндекс это действует, то с Гуглом в этом плане могут возникать проблемы, так как он может действовать по своему усмотрению.

Есть также специальный сервис Pr-cy.ru, позволяющий получить вебмастерам различные данные по сайтам – в том числе, число страниц, проиндексированных в Гугле и Яндексе. Чтобы узнать эту информацию, нужно посмотреть на две нижние колонки соответствующих поисковых систем.

Что помогает ускорить индексацию сайта

Чтобы страницы быстрее индексировались, нужно придерживаться главных правил:

Регулярное размещение уникальных и оптимизированных статей. Поисковый робот возьмет себе за привычку регулярно посещать тот сайт, на котором с определенной периодичностью размещается качественный, полезный и интересный контент.

Анонсирование о размещении нового контента или полезных обновлениях на сайте через социальные сети. После того, как появилась статья, можно самостоятельно сообщить об этом в социальную сеть с помощью кнопки retweet. Поисковый бот отметит это и зайдет на сайт через социальную сеть значительно быстрее.

Поисковому роботу гораздо проще найти конкретную страницу с помощью ссылки, имеющейся на вашем сайте

То есть, не стоит забывать о важности внутренней перелинковки.

Добавив xml-карту в панель вебмастера, мы даем возможность поисковому боту пройти по ней. Также ее нужно добавить в robots.txt

Полезна и карта сайта (карта для человека), по которой бот отыщет все страницы сайта.

В материале мы рассмотрели основные способы, позволяющие проверить, попали ли страницы сайта в индекс различных поисковых систем. Некоторые из них более эффективные, а какие-то – менее, но каждый из них имеет право на существование и использование.

Читайте далее:

Методы ускорения индексации сайта в яндексе

Seo — проверка индексации текста и веса ссылок тест

Быстрая индексация сайта в Гугле

Индексация ссылок

Проверить картинки на уникальность

Как скрыть персональные данные в поисковых системах?

Полезные ссылки

Мне остается только посоветовать несколько источников, которые помогут научиться писать крутые статьи, которые с радостью одобрит и Яндекс, и Гугл. Первый сервис GeekBrains.ru. Он больше подойдет тем разработчикам, которые хотят добиться совершенства в выбранной области.

Здесь в течение 4 месяцев обучают профессии «SEO-специалист». То, что пишут на странице о курсе – не совсем правда. «Стоимость обучения с легкостью компенсируется уже за 1 месяц работы». От вас потребуется всего 4,5 тысячи рублей, а эту сумму можно «отбить» уже за неделю.

Здесь не учат писать, они рассказывают о коде, составлять семантическое ядро сайта, то есть придумывать его структуру, о чем вы будете писать в блоге, далее внутренняя оптимизация – какие слова использовать в публикациях, чтобы их лучше видели поисковые системы. Внутренняя и внешняя оптимизация, а также контекстная реклама.

Все это очень полезно для веб-мастера. По завершению обучения вы можете пройти стажировку в крупных компаниях, GeekBrains.ru подыскивают вам места. Это не совсем курс. Вы будете работать с учителем, выполнять домашние задания и учиться на практике.

Если же вас больше интересует владение словом, то я могу посоветовать закрытый клуб копирайтеров «Повелители пера»

Не важно начинающий вы копирайтер или хотите усовершенствовать свои навыки

За 490 рублей в месяц у вас будет доступ к огромному количеству материалов по копирайтингу школы Юлии Волкодав: виды продающих текстов, как выиграть тендер на бирже фриланса, вау-текст, эффективные заголовки и многое другое.

Сумму, потраченную на обучение, вы можете «отбить» уже в первый день. Учитывая, что средняя цена за 1000 символов на бирже фриланса составляет около 50 рублей, то вам всего-то понадобится написать две статьи, длиной в 5 тысяч знаков.

Вы научитесь продавать

Что очень важно для ведения своего сайта. Ваши продукты будут уходить быстрее

Одна публикация может продавать снова и снова, помните об этом. Всего одна хорошая статья в неделю, написанная вами и качественно, будет работать долгие годы и приносить прибыль.

Ну вот и все. До новых встреч и не забывайте подписываться на рассылку.

Особенности индексирования сайтов с разными технологиями

Ajax

Сегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации и Google, и Яндекс есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам

Для этого в robots.txt нужно добавить такие команды:

Поисковые роботы Яндекса тоже могут индексировать сайты на AJAX, но при одном условии ― если у каждой страницы сайта есть HTML-версия. В справочнике Яндекса можно узнать подробнее, как сообщить роботу об HTML-версии страницы.

Флеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи. Поисковые роботы Яндекса индексируют только тот текст во Flash-документах, который размещен в таких блоках: DefineText; DefineText2; DefineEditText; Metadata.

Поэтому не удивительно, что поисковики предлагают не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash, пользователям мобильных устройств (они не отображают flash-контент), так и поисковым роботам Яндекса.

Фреймы

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самих поисковиков: Яндекс индексирует контент внутри тегов <frameset> и <frame> и не индексирует документы, подгружаемые в тег <iframe>. А вот Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Как сохранить метку на карте

В Яндексе и Google разное количество проиндексированных страниц: что делать?

На данном этапе вы уже знаете, какие страницы не проиндексированы. Но почему так произошло?

Вот причины, по которым поисковики могут индексировать не все (или лишние) страницы:

- Разные директивы для роботов Яндекса и Google в robots.txt. В этом случае – ошибочно или намеренно – запрещена индексация определенного типа страниц для Googlebot или Yandexbot; проверьте файл robots.txt и при необходимости исправьте директивы.

- Молодой сайт. Требуется время, чтобы поисковики добавили все страницы в индекс; если спустя 2-3 месяца после запуска сайта проблема не решилась, ищите другие причины.

- Нет XML-карты сайта. Она помогает роботам ПС эффективней сканировать сайт, поэтому ее стоит обязательно создать и указать путь к ней в robots.txt.

- Наличие дублей страниц. Возникают в силу специфики CMS, ошибок при разработке и настройке сайта, копировании контента. Решение – найти и устранить дубли.

- Низкая скорость работы сайта. Робот может попросту не дождаться ответа и уйти ни с чем. Решение – найти «узкие места» и ускорить работу сайта.

- Редкое добавление контента. Чем реже вы добавляете новые страницы, тем реже роботы посещают сайт. Естественно, скорость переобхода у Яндекса и Google разная, поэтому возникают расхождения. Решение — хотя бы раз в неделю создавать новую страницу с уникальным контентом, например, статьей для блога. Если у вас не хватает времени для работы над контентом, подключите модуль автоматического наполнения сайта от PromoPult – копирайтеры будут регулярно писать тематические тексты под ваш сайт, а верстальщики – размещать их на страницах.

- Редкое обновление устаревшего контента. Если существующие страницы не обновляются, то при выпадении из индекса повторная индексация произойдет не скоро. Избежать этого помогает настроенный Last-Modified и регулярная актуализация информации.

- Санкции поисковиков. Ваш сайт может попасть под фильтры одного из поисковиков. В этом случае стоит проверить сайт на наличие фильтров.

- Более 4-х уровней вложенности. В такой ситуации поисковик не успевает добраться до части «глубоких» страниц. Решение –переосмыслите структуру сайта, максимально упростите ее.

После устранения недостатков подождите пару недель, чтобы поисковики переиндексировали страницы, и повторно промониторьте ситуацию. Если все сделано верно, то расхождения минимизируются (ожидать, что совпадать будут 100% страниц, не стоит).

Почему индексация должна быть быстрой?

Кроме увеличения трафика посетителей скорость индексирования влияет и на многие другие показатели ресурса.

Ежедневно в сети появляются новые сайты, тематика которых конкурирует с вашей веб-площадкой. Все они наполняются схожим контентом, который по мере роста численности конкурентов, теряет свою уникальность. Это происходит оттого, что большинство сайтов занимается публикацией многочисленных рерайтов. Простым языком, если вы написали уникальную статью и сразу не позаботились о ее учете поисковиком, не факт, что в момент такового материал останется уникальным.

Кроме того, не проиндексированный контент становится лакомой мишенью для мошенников. Недобросовестному веб-мастеру ничего не мешает попросту скопировать материал на свой ресурс, провести быстрое индексирование и получить от поисковых роботов право на его авторство. А вашу статью поисковики в дальнейшем сочтут не уникальной, что может привести к бану интернет-площадки

Поэтому контролировать и ускорять процесс индексации особенно важно для молодых ресурсов, пробивающих себе дорогу

Еще одним моментом, зависящим от быстрого индексирования каждой страницы, является возможность получать деньги за платные ссылки. Ведь до тех пор, пока статья с ссылкой не будет проиндексирована поисковиками, свое вознаграждение вы не получите.

Как проверить индексацию отдельной или всех страниц

Проверка отдельной странички нужна, когда необходимо убедиться, что новый опубликованный контент успешно «замечен» поисковыми системами. Или когда вы приобрели на чужом ресурсе платную ссылку и теперь с нетерпением ждете ее индексации. Это можно сделать через:

- Ввод URL страницы в строку поиска Яндекс или Google. В случае если проблем с восприятием страницы поисковиками нет, она первой отобразится в результатах поиска.

- Уже упомянутый плагин RDS Bar.

Для проверки индексации всех страничек сайта понадобится список их адресов (URL). Для этого можно воспользоваться каким-либо генератором карт веб-ресурсов, к примеру, Sitemap Generator. Чтобы собрать только URL страниц, не забудьте внести маску ненужных адресов, например, на комментарии, в окне «Exclude Patterns». По окончании процесса следует перейти во вкладку Yahoo Map/Text, откуда скопировать сгенерированный перечень всех адресов.

Имея его на руках, индексацию всех страничек не составит труда проверить с помощью программы YCCY.ru. Просто добавьте данные в список исходных URL и выберите одну из предложенных поисковых систем: Google, Яндекс или Rambler. Нажмите кнопку «Начать Проверку» и получайте утешительные или не очень результаты.